アナリティクスサービス本部の辻 陽行です。

「Google Cloud Next `19 San Francisco(以下、Cloud Next)」で開催された数多くのセッションのうち、今回は3つのセッションから、AI/ML関連のGCPサービスの事例を中心に紹介させていただきます。

<目次>

- AI/ML関連のセッションのご紹介

- Automating Tax using Google Cloud Platform, (it really can be done!)

- The future of AI for speech-based collaboration

- Cloud for Good - Leveraging Data, Machine Learning, and AI for Social Good

- まとめ

AI/ML関連のセッションのご紹介

近年、GoogleはAIやMachineLearningに関連するサービスを次々とリリースしており、Cloud Nextが開催された3日間の中でもAI関連のセッションが数多くありました。

私の職種がデータサイエンティストであることもあり、参加したほとんどのセッションはAI/MLに関するものでした。

純粋なGCPのAI関連サービスの紹介は、Keynoteや常設ブースでの説明がメインで、個々の会場で実施されるセッションはGCPのサービスを用いた具体的なソリューションや、ビジネスでの適用例のプレゼンテーションが多かったように思います。

今回は、私が参加したセッションのうち、特に興味深かった以下3つのセッションを紹介します。

●Automating Tax using Google Cloud Platform, (it really can be done!)

●The future of AI for speech-based collaboration

●Cloud for Good - Leveraging Data, Machine Learning, and AI for Social Good

Automating Tax using Google Cloud Platform, (it really can be done!)

セッション概要

pwc社がGCPのサービスを用いて、請求書の税金処理を自動化するサービスを開発していくプロセスを紹介するセッションに、参加しました。

これまでは、オーストラリアでPoCを実施しており、これから本格的なサービスの導入が始まるとのことでした。

セッションでは、オーストラリアやEU諸国で導入されているVAT(付加価値税)の処理についても、細かく触れられていましたが、本ブログではその点については深く触れず税金と表現させていただきます。

ビジネス課題

・これまで請求書に記載されている物品にかかる税金に関する処理は、その複雑さからマニュアルによる作業に依存していた

・また、地域・国によっても税の適用ルールは異なっているため、適用地域・国に応じた複雑な仕分けルールを適用する必要がある

・マニュアルによる仕分け作業は膨大な費用を要するだけでなく、処理の誤りが発生する原因となっている

・一方、請求書のフォーマットは多様性があり、税処理に必要な項目を機械的に正確に抽出することもこれまでは容易ではなかった

解決アプローチ

上記の課題を解決するためには、①どのような請求書フォーマットであっても記載事項を正確に読み取る画像解析技術と、②複雑な税金処理を適切に処理するためのアルゴリズムの2つが必要となります。

このセッションでは以下のステップで解決を図るサービスが提示されていました。

解決までのステップ

1. 様々なフォーマットで記述されている請求書ファイルをシステムにアップロード

2. 請求書の画像情報を読み取り必要な項目を抽出

3. 現地の税制に基づいて内容を評価

4. 評価した内容を元に要件を満たすように必要項目を自動で記入

5. ダッシュボードに分類結果が表示されいつでもレビュー可能

1:様々なフォーマットで記述されている請求書ファイルをシステムにアップロード

様々なフォーマットで記載されている各種請求書ファイル(pdfファイル)を、クライアントがpwcの提供するERPサービスにアップロードする工程が最初の作業となります。

2:請求書の画像情報を読み取り必要な項目を抽出

ファイル化された請求書を、GoogleVisionAPIとGoogleTranslate、学習済みOCRモデルを用いて、必要な処理項目を自動抽出します。

請求書によっては国も異なりますし、請求書の形式も違いますが、VisionAPIで記載項目の位置を判別し必要な項目を正確に抽出することに成功しています。

請求書の記載言語が英語でない場合でも、GoogleTranslateが英語へ翻訳した上で必要項目の抽出が実施されます。

3:現地の税制に基づいて内容を評価

読み取った内容を元に、現地での税金の適用ルールに沿った仕分けが実施されます。

税金の適用ルールを識別するモデル自体は、pwcが独自に学習したExpenseModelと呼ばれるものを用いて、分類が行われているとのことでした。

4:評価した内容を元に要件を満たすように必要項目を自動で記入

ExpenseModelで評価した税分類に基づいて、必要項目が自動で起票され画面に表示されます。

ここまでの工程で人手による作業が必要な部分は、請求書ファイルのアップロードぐらいのもので、ほとんどの工程が自動化されていることがわかります。

5:ダッシュボードに分類結果が表示されいつでもレビュー可能

自動で分類された請求書は、適用された税の種類ごとにサマリダッシュボードも用意されており、自動処理された結果をいつでもレビューできる状態が構築されています。

データサイエンティストの視点から

本セッションの内容を聞いて、2つ重要な示唆があると感じました。

1点目は、請求書に記載されている文字やその位置関係を正確に読み取るといった様な、一般的な物体検知タスクは、GCPのAIサービスを活用することで十分な精度が得られる状態にあること。

2点目は、税制の違いに応じた必要項目の仕分けタスクといった個別の課題については、独自の識別モデルが用いられており、単にGCPサービスを活用するだけでは同様のERPサービスは展開できず、個別の問題に関する知見・データに基づいたモデルを構築することで、独自の強みを持ったERPサービスとして成立していること。

このセッションに限らず、GCPが得意とする一般的な物体認識や文字認識の様なタスクはGCPに任せてしまい、自社の事業ドメインで重要となる部分の問題にフォーカスすることで、効率的に問題の解決を図っている事例が多く報告されていました。

自身でも経験がありますが、データサイエンティストは目の前にある分析課題を自分達で一つづつ解決しようと、自前でモデルを作ってしまいがちです。

しかし、自分たちがフォーカスすべき課題以外は、GCPなどの別のAIサービスで代替しながら、効率的に仕事をすると選択肢を持たねばならないと、感じるセッションとなりました。

セッションの動画

youtu.be

The future of AI for speech-based collaboration

セッション概要

GCPのAIに関連するサービスを用いた問題解決の事例を、2例紹介するセッションに参加しました。

AES社の事例

1つ目に、風力発電などのインフラサービスを提供するAES社の事例が紹介されました。

AESが抱えていた課題をGCPを用いてどのように解決したかについて、簡単にまとめさせていただきます。

ビジネス課題

・AESはこれまで、保有する大規模な風力発電装置の設備維持管理を、人手による確認に依存してきた

・しかし、人手による補修箇所の確認を実施するのは単にコストが掛かるだけでなく、補修箇所の確認には風力発電装置という高所での危険な作業が伴う

・可能な限り風力発電装置の補修が必要かどうかの判断を安全で効率的に実施していきたい

上記のような課題を解決するために、ドローンによる風力発電装置の撮影と撮影された画像から修繕が必要な傷の有無を、自動で検知するアプローチが取られることになりました。

解決アプローチ

今回の問題を解決するには、広大な土地に広がる風力発電装置の羽部分や塔部分を鮮明な画像で撮影できる装置と、その撮影された画像を元に傷を検知し、修繕が必要なタイプのものかどうかを判別する必要があります。

解決までのステップとしては、

1. 風力発電装置の画像を撮影

2. 撮影された画像から傷と思われる部分を検出

3. 傷の種類をラベリング

4. ラベリングされた傷に応じて補修の必要性の有無を判断

5. 補修の必要性があるものについては補修を実施する

といった工程を踏んでいくことになります。

1:風力発電装置の画像を撮影

画像の撮影に関しては、高画質な画像の撮影が可能なドローンが風力発電装置の周りを旋回し撮影することで、解決を図ることに成功しました。

セッションでは、このドローンの活躍により、現場での危険な確認作業を行う時間が57,000時間短縮された、と報告されていました。

2: 撮影された画像から傷と思われる部分を検出

次に、撮影された画像からどのように傷を検知していくかですが、ここからGCPのサービスが活用されることになります。

Cloud AutoML Visionを用いて、集められた画像から装置に傷がついていると思われる部分を抽出します。

Cloud AutoML Visionはブラウザ上で画像をアップロードして、画像にラベルを付与するだけで画像分類を実施することができます。

これにより、画像分類に関する専門的な知識を持たないユーザーでも、高精度な画像分類問題に取り組むことができるようになっています。

セッションでも、ドローンから撮影された風力発電装置の画像がAutoML Visionに取り込まれて、学習モデルが作成されている様子が紹介されていました。

3:傷の種類をラベリング

次に、傷の種類に応じてその傷がついていると思われる画像に対して、ラベルを付与していきます。

このラベルを付与する作業自体は、GoogleのDataLabelingServiceを利用したとのことでした。

弊社でも同じような経験がありますが、画像にラベルを付与していく作業(アノテーション)はなかなか自動化が難しく、今後も画像を用いたAIソリューションが生み出される過程で大きな課題となってくる部分だろうと思われます。

4:ラベリングされた傷に応じて補修の必要性の有無を判断

最後に、ラベリングされた傷が、補修が必要な傷なのかそうでないのか、判断を行う必要があります。

セッションでは、「Damage Definition」と定義されていましたが、この工程についてはやはりAESの業務を担当しているメンバーが、その必要性の有無を定義しているとのことでした。

5:補修の必要性があるものについては補修を実施する

セッションでは、実際の補修に向かう条件は特に触れられていませんでした。

ここからは私の想定となりますが、実際に補修に向かう場合を考えると、①実際に補修する必要があるケース、②補修の必要性の判定に誤りがあり補修の必要ないケース、の2種類のケースが考えれます。

実際に、本ケースのような補修作業の必要性の有無を自動で判定する仕組みをオペレーションに組み込む場合には、①のように判断が正しかった場合に得られる利益と、②のように判断が誤っていた場合に支払うコストを勘案して、「補修の必要性があるとみなす」スコアの閾値を設計する工程も発生することが想定されます。

こうなってくると、今度は予測値を用いた最適化の問題を解く必要も出てきます。このように、単に予測の問題にだけフォーカスしていれば全てが解決するというわけでないのが、実際の業務においては解決が困難なところであり、データサイエンティストが価値を発揮できるところだと考えられます。

成功の秘訣

セッションでは、具体的な課題解決のアプローチだけでなく、本取り組みが上手くいった要因に関する分析も行われていました。

特に成功の秘訣として触れられていた点は、「IT部門以外の人間もこのPJに関与し、コミットメントしていたこと」でした。

現場で働いている関係者も巻き込みながら、「検証」→「プロトタイプ作成」→「製品化」を1サイクルあたり3週間で繰り返すことで、モデルのブラッシュアップが早期に図られたことがプロジェクトの成功において重要だったとのことでした。

LGの事例

2つ目の事例として、LGでのカメラ画像を用いた不良検知サービスのケースが紹介されました。

ビジネス課題

・クッキーのような加工食品は、製造工程の中で一定数の不良品が発生してしまうため、不良を正確に検知することが重要

・これまでは不良品の判別をルールベースで実施していたが、十分な精度が得られなかった

・精度を改善させるために自社のMLチームで深層学習を用いたモデルを検討していたが、新たなモデルはデプロイまでに時間がかかることがネックとなっていた

解決アプローチ

本事例の特徴は、ルールベースの識別モデルを改善するためにGCPのAIサービスを用いる前からMLチームが存在し、何度かモデルの改善にトライしていたことでした。

ただ、ビジネス課題の部分にもある様にMLチームのメンバーがそれぞれモデルを開発し、そのモデルをデプロイする作業を内製化しようとすると、マネージメントコストやモデルの開発に多くの時間が割かれてしまうため、持続的かつ効率的な改善につながりにくい状態となっていたそうです。

そこでMLチームの役割のうち、モデル作成からデプロイまでの部分をAutoML Visionで代替することにし、AutoML Visionにデータを投入するまでの前処理部分を、MLチームが担当する様に役割が変更されました。

結果として、AutoML Visionの導入によって、モデルのデプロイにかかる期間が7日から2時間に短縮され、精度もAccuraryが6%改善するという成果が得られたとのことでした。

AutoML Visionの活用によってMLチームメンバーは、データの質をあげる、データの前処理を精緻にする、などドメイン知識が必要な領域に時間を割ける様に働き方が変化してきています。

データサイエンティストの視点から

どちらの事例もAutoML Visionを活用した事例が紹介されていましたが、

AESの事例からは、画像認識のプロでなくとも自分たちが必要としている課題を適切に処理できるAIインフラがすでに用意され活用されている現実を再確認し、

LGの事例からは、モデルのデプロイや管理コストを考えると、データサイエンティストが試行錯誤しながら自前でモデルを作成するよりも、AutoMLVisionの様なAIサービスにモデル作成部分を任せてしまった方がプロジェクト全体の改善スピードを早められる可能性を、突きつけられた気がしました。

どちらも画像分類系の活用事例でしたが、この手の話は画像系のタスクに限らずより一般的な予測や判別のタスクにも当てはまるだろうことを考えると我々データサイエンティストはその働き方を変えていく必要があるのでしょう。

Cloud for Good - Leveraging Data, Machine Learning, and AI for Social Good

セッション概要

自然災害の予測や海上交通の状況の把握など、社会全体にとって有益なAIの活用をビジネスとして展開している2つの事例を紹介しているセッションに参加しました。

それぞれセッションの時間こそ短かったものの、自然災害の早期検知や被害地域の予測など従来の技術では解決が難しかった問題に取り組んでおり、AIやそれを支える技術インフラの重要性が増大してきていることを感じることができる素晴らしいセッションでした。

どちらも10分ほどの短いセッションでしたので、簡単に概要だけをまとめています。

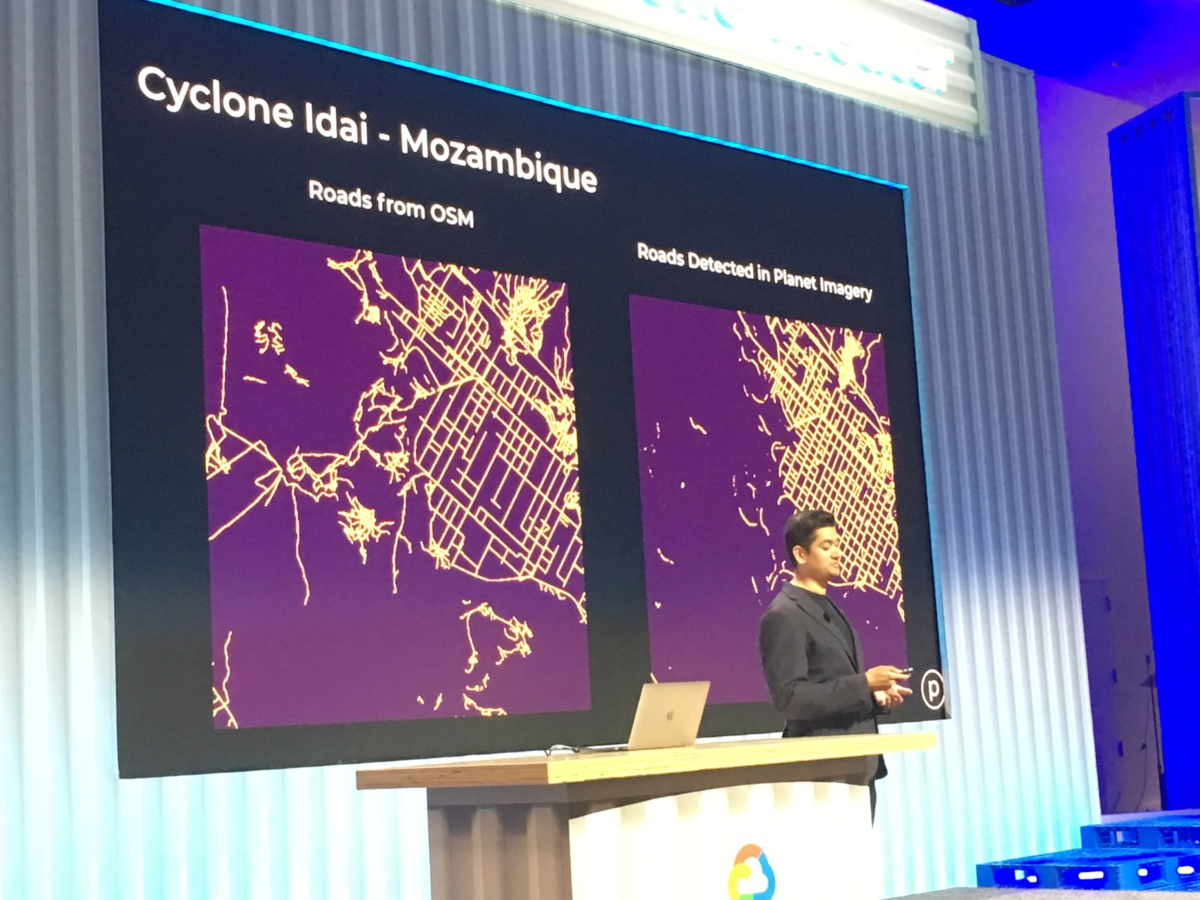

Planet labsのケース

Planet Labsは、Dovesという衛星機器を打ち上げ、常にその衛星機器で地球をモニタリングしており、その情報からサービスを提供しています。

例えば、衛星機器から得られた情報を元に嵐のエリアの調査を実施し、大規模な被害が出る前に嵐の位置を検知するサービスを提供しています。

衛星からの情報を元にすれば、モザンビークのようなインフラの整わない場所で、事前に嵐の発生や進路を検知することが可能であり、安全な道をアシストすることも可能となります。

上記の様に、セッションでは衛星画像から市街地の状態を識別し、嵐が発生しているポイントを描画するデモが実施されていました。

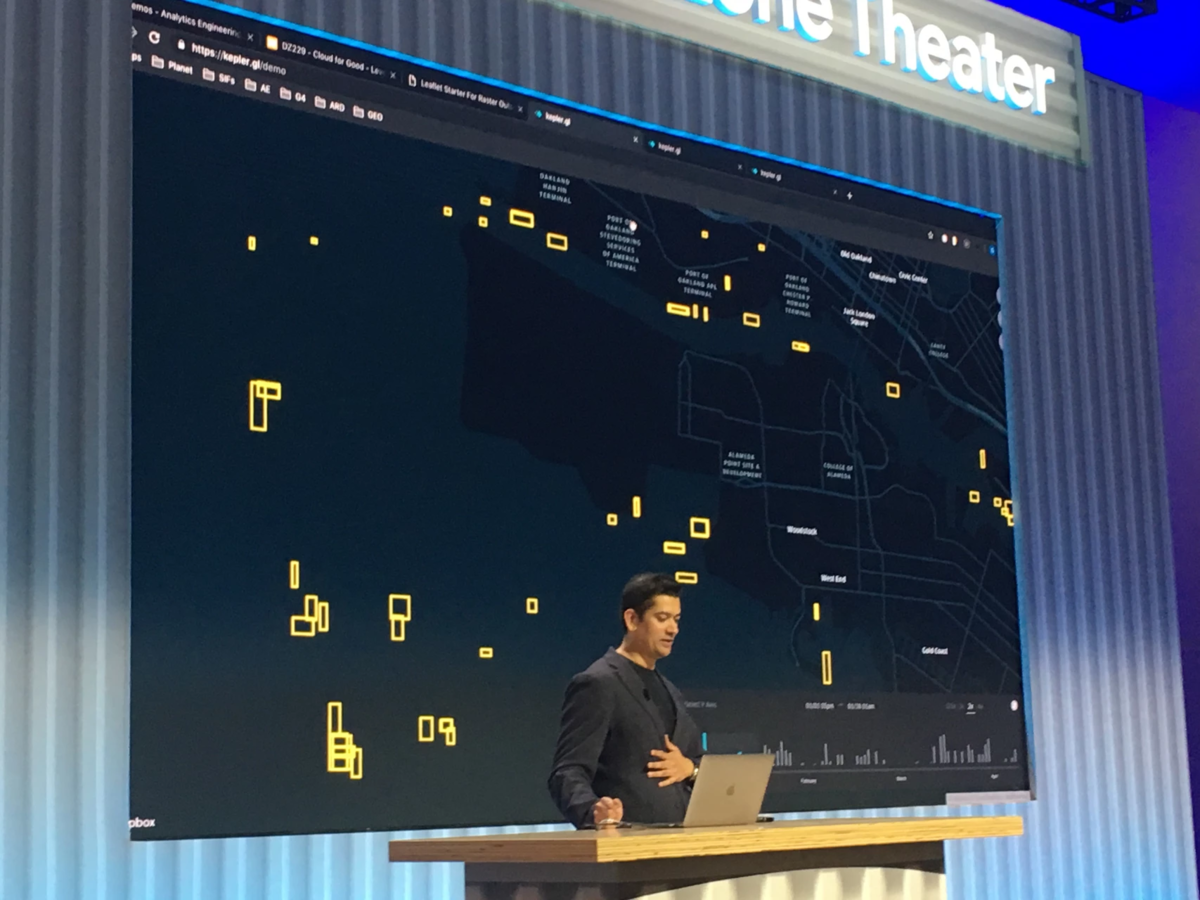

また、別の事例として、海上活動の監視なども実施していることが紹介されていました。

衛星から送られてくる情報を使ってリアルタイムに船舶の状態を監視することができ、南シナ海で船舶がどのように航行しているかなども、リアルタイムに監視できると紹介されていました。

パナマ運河のように、船の渋滞が起こる部分を重点的に監視しておくことで、別のルートを案内するなどのサービスが可能となります。

上記では、運河周辺に集まっている船舶をリアルタイムで監視している様子を表したデモが、実施されていました。

画像から船舶を識別する物体検知などのタスクをVisionAPIやAutoML Visionを用いてサービスに組み込んでいるようでした。

Mayday.aiのケース

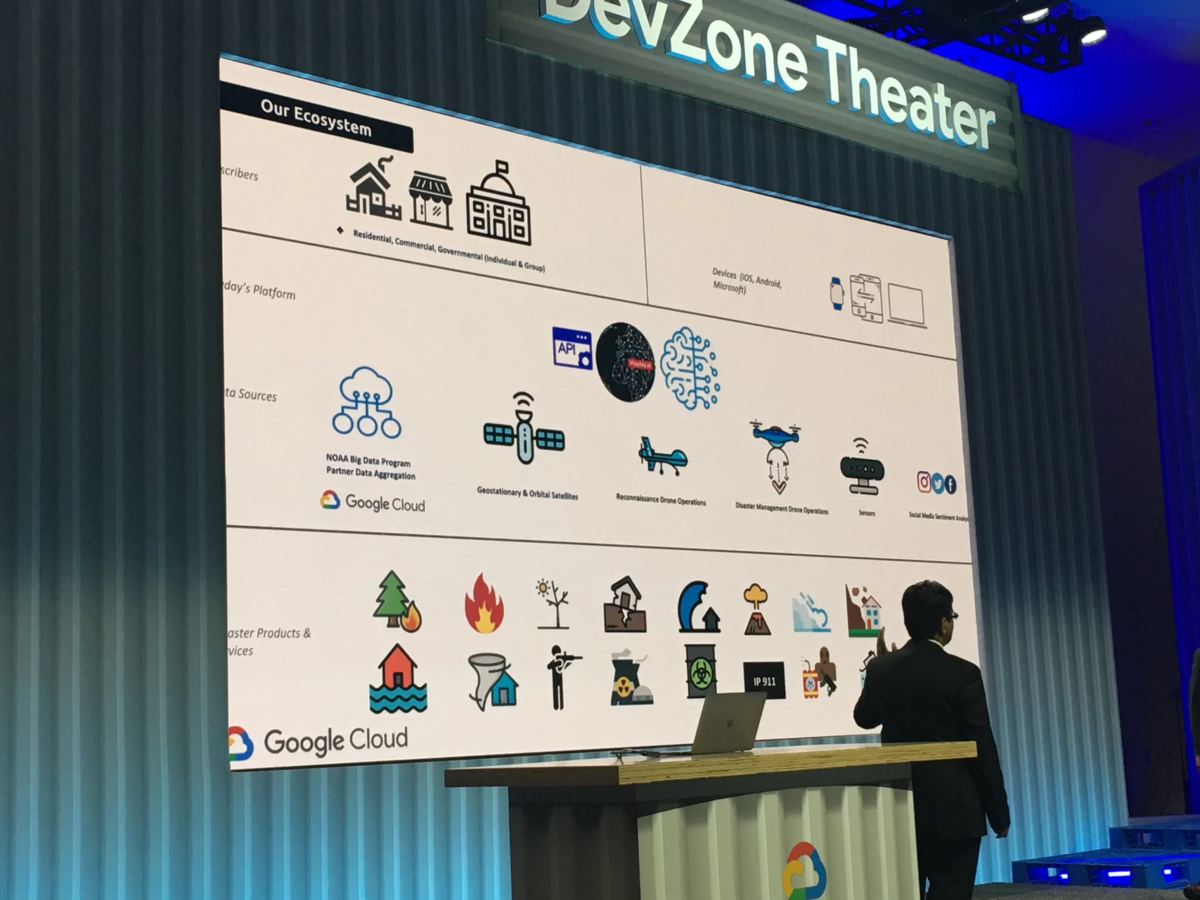

セッションの後半では、災害管理を行うMayday.aiの事例が紹介されました。

AI技術を用いて災害が発生している(しそう)なことを通知するサービスを展開しており、災害の種類も豊富で山火事から干ばつ、地震、噴火、放射能被害、津波、戦争など様々なシチュエーションに対応しているとのことでした。

こちらのケースでも情報源は人工衛星や飛行機、ドローンなど色々な方法によって世界中の情報を収集しているとのことでした。

AutoML Visionで災害が発生していると思われる画像にラベルを付与して学習させることで様々な災害の種類を識別できるようにモデルを構築していっているとのことでした。

データサイエンティストの視点から

ドローンや飛行機などを通して得られた情報を活用し、これまで簡単に調査や援助ができなかったエリアなどの災害を事前に防ぐためにAIが活用され始めており、AIの活用の幅が単にビジネスに留まらず世界の人の生活そのものを変化させるまでになっていることに衝撃を受けました。

普段仕事をしていると、AIの活用のされ方がコスト削減や効率化といった文脈でしか語られないことが多く、AIが社会に与えるインパクトはまだまだ大きくないと感じることもあったのですが、これらの事例を聞くことで問題の設定の仕方次第なのだと、考えを改めさせられました。

セッションの動画

www.youtube.com

まとめ

今回は、AIやMLに関連するGCPのサービスを用いた事例を3つ紹介させていただきました。

紹介した事例はどれも、自社で抱えている問題を全て自社リソースで解決しようとした場合、優れたデータサイエンティストの確保や物体認識のための学習用のデータの蓄積・高額な計算リソースへの投資といった、数多くの人的・技術的制約によって解決が難しいと見なされていたものばかりだったように思います。

GCPのサービスで自身の課題が全て解決するわけではないものの、取り組むべき課題の本質的な部分にフォーカスできるような環境が揃いつつあり、その流れは加速していっていることを肌で感じました。

また、優秀なデータサイエンティストや十分な計算リソースを保有している企業ですら、モデルのデプロイやマネージメントにかかるコストを削減するためにGCPを選択することもあるのですから、AIを取り巻くビジネスの環境は今後、自身が保有するデータやドメイン知識を強みとしたサービスを展開していかないと、あっという間にコモディティ化してしまうのだろうと予感させられました。

ブレインパッドでは、データサイエンティストを募集しています!実際のビジネスで自分の知識・技術を活用してみたいという方、ぜひエントリーください!

www.brainpad.co.jp

※Google、Google Cloud Platform、GCP は、Google LLC の登録商標、または商標です。